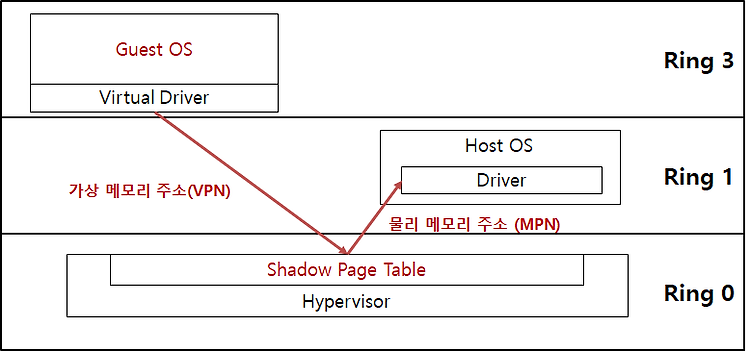

1. 메모리 가상화: VMware 기법 VMware는 한대의 컴퓨터로 마치 여러 대의 컴퓨터를 사용하는 것 같은 가상의 공간을 만들어 주는 프로그램 VMware는 하이퍼바이저 내에 Shadow Page Table을 별도로 두어 VPN과 MPN의 중간 변환 과정을 가로챔 (매핑) 매핑 연산을 하드웨어적으로 도와주는 것을 TLB(Translation Lookaside Buffer) 하이퍼바이저의 핵심 모듈은 VMkernel VMkernel: 서비스 콘솔, 디바이스 드라이버들의 메모리 영역을 제외한 나머지 전체 메모리 영역을 모두 관리하면서 가상머신에 메모리를 할당 * 예시) 가상 머신 메모리 할당 - 예를 들어, 여러 개의 가상머신이 동시에 수행중인 경우라면 위의 그림과 같은 메모리 사용 상황이 발생할 수 ..